Fall eins. Eine junge Frau, die nicht mehr mit ihrem Freund zusammen sein will, fragt ihren Chatbot, wie man so eine Trennung gut über die Bühne bringt. Sie will wissen, was moralisch richtig ist, und sie sucht jemanden, der es ihr sagt.

Fall zwei: Ein junger Mann will sich vor einer Prüfung drücken. Der Chatbot ist dagegen, aber der junge Mann fragt immer weiter, unter welchen Umständen es vielleicht doch vertretbar wäre, daheimzubleiben. Am Ende hat er die KI so weit: Er muss nicht zur Prüfung.

Fall drei: Eine junge Suchtpatientin kommt zur Therapeutin. Vorher hat sie ihren Chatbot gefragt, ob sie ehrlich sein soll, am Wochenende hatte sie einen Rückfall. Die Therapeutin ist beruhigt: Die KI hat sich auf ihre Seite geschlagen.

Die Chatbots sind in unserem Alltag angekommen. Wissenschaftler rechnen damit, dass Zeiten nahen, in denen Menschen lieber ihren Computer um Rat fragen als andere Menschen. In einer im Sommer veröffentlichten Studie gaben 72 Prozent der befragten amerikanischen Teenager an, Chatbots zu nutzen, wenn sie Trost oder Rat suchen. Die KI berät auch bei Moralkonflikten. Die Leute vertrauen ihr. Die KI urteilt nicht. Selbst wenn sie es täte, wäre es egaler als das Urteil der Nachbarin. Ob man sich auf ihre Moral verlassen kann, ist eine andere Frage.

Überzeugen können sie

Bevor es Sprachmodelle wie ChatGPT und Claude gab, nutzten Leute oft Reddit, um dort den anderen anonymen Nutzern heikle moralische Fragen vorzutragen, ohne schräg angeschaut zu werden. Die Antworten kamen von Fremden, aber sie kamen von Menschen, einer Schwarmintelligenz. Beim Chatbot ist es gewissermaßen nicht ganz anders. Der Chatbot kennt schließlich all die menschlichen Einschätzungen aus dem Internet.

Im Herbst 2023 legten Wissenschaftler der Universität Pennsylvania Studenten, Ethikexperten und zufällig ausgewählten Befragten Antworten auf ethische Fragen vor. Sie stammten entweder vom Philosophen und „New York Times“-Kolumnisten Kwame Anthony Appiah oder von einer KI, die an seinen Antworten trainiert worden war. Insgesamt schnitten die Antworten der KI besser ab, so wie in einer Studie der University of North Carolina, in der ihr die Mehrheit der 900 Teilnehmer bescheinigte, „moralischer, vertrauenswürdiger, aufmerksamer und korrekter“ vorzugehen.

Überzeugen können die Chatbots also. Aber wie sollen sie unseren Moralvorstellungen entsprechen? Was ist mit strittigen Moralurteilen? Solchen, die von Situation zu Situation variieren? Und solchen, die sich im Verlauf der Zeit verändern? Sollte der Chatbot das Wohl der Mehrheit im Sinn haben – oder den Vorteil seines Gesprächspartners? Mit diesen Fragen befasst sich die Wissenschaft seit Jahren, auch damit es hinterher nicht heißt, wir hätten es besser wissen müssen.

Das Max-Planck-Institut für Bildungsforschung befindet sich in Berlin-Wilmersdorf an der Grenze zu Dahlem, einer Gegend von Berlin, in der die Bäckereiverkäuferinnen ihre Kunden mit Namen kennen. Von außen sieht es wie eine unsanft gelandete Raumkapsel aus, ein verwinkelter, hingeduckter Kasten. Innen fällt von allen Seiten in langen, sich überlagernden Streifen das Licht herein, und Iyad Rahwans Büro im dritten Stock gibt den Blick frei auf die letzten bunt belaubten Bäume. Rahwan ist hier seit 2019 Direktor des Zentrums für Mensch und Maschine. Gerade hat er einen internationalen Preis für seine interdisziplinären Beiträge zum Verständnis komplexer Systeme gewonnen, der dazugehörige Pokal steht noch auf dem Sofatisch, und Rahwan macht bei der Begrüßung einen Scherz darüber, dass er natürlich da steht, um Eindruck zu schinden.

Für einen ehemaligen Informatikprofessor ist Rahwan sehr menschengeprüft. Das könnte auch daran liegen, dass er mit seinem Team täglich Verhaltenswissenschaften betreibt. Er erforscht das Verhalten von Maschinen mit KI empirisch wie soziale Organismen, als Teil sozialer Strukturen und Interaktionen, die sich auf unsere Welt, Werte, Vorurteile und moralischen Entscheidungen auswirken.

Ein treuer Gefolgsmann

Gerade haben Rahwan und seine Leute eine neue Studie veröffentlicht. Versuchspersonen konnten ein Würfelspiel, bei dem sich Geld gewinnen ließ, an eine KI delegieren. Es stellte sich heraus, dass Menschen in Zusammenarbeit mit KI eher dazu neigen, zu schummeln. Weil sie weniger moralische Verantwortung spüren? „Wenn eine Maschine übernimmt, lassen sich die Folgen bestimmter Entscheidungen anscheinend besser ertragen“, sagt Rahwan. Außerdem ist die KI ein treuer Gefolgsmann: „Frag einen Freund, ob er für dich betrügt: Die Chancen stehen 50 zu 50. Ein Bot aber hält sich in 80 bis 90 Prozent der Fälle daran.“

So arbeitet Rahwans Team: Es versucht, Probleme vorauszusehen, die auf uns zukommen, wenn die KI überall mitentscheidet. Dann macht es sich auf die Suche nach Lösungen. Wenn bekannt ist, dass Menschen eher zum Betrügen neigen, sobald sie Aufgaben an eine Maschine delegieren, muss also entweder die Bauart der Maschine verändert werden. Die KI könnte zum Beispiel weniger gehorsam sein. Oder man könnte die Absprachen aufnehmen, damit sich zurückverfolgen lässt, wer verantwortlich ist. Es geht darum, einen Schritt voraus zu sein.

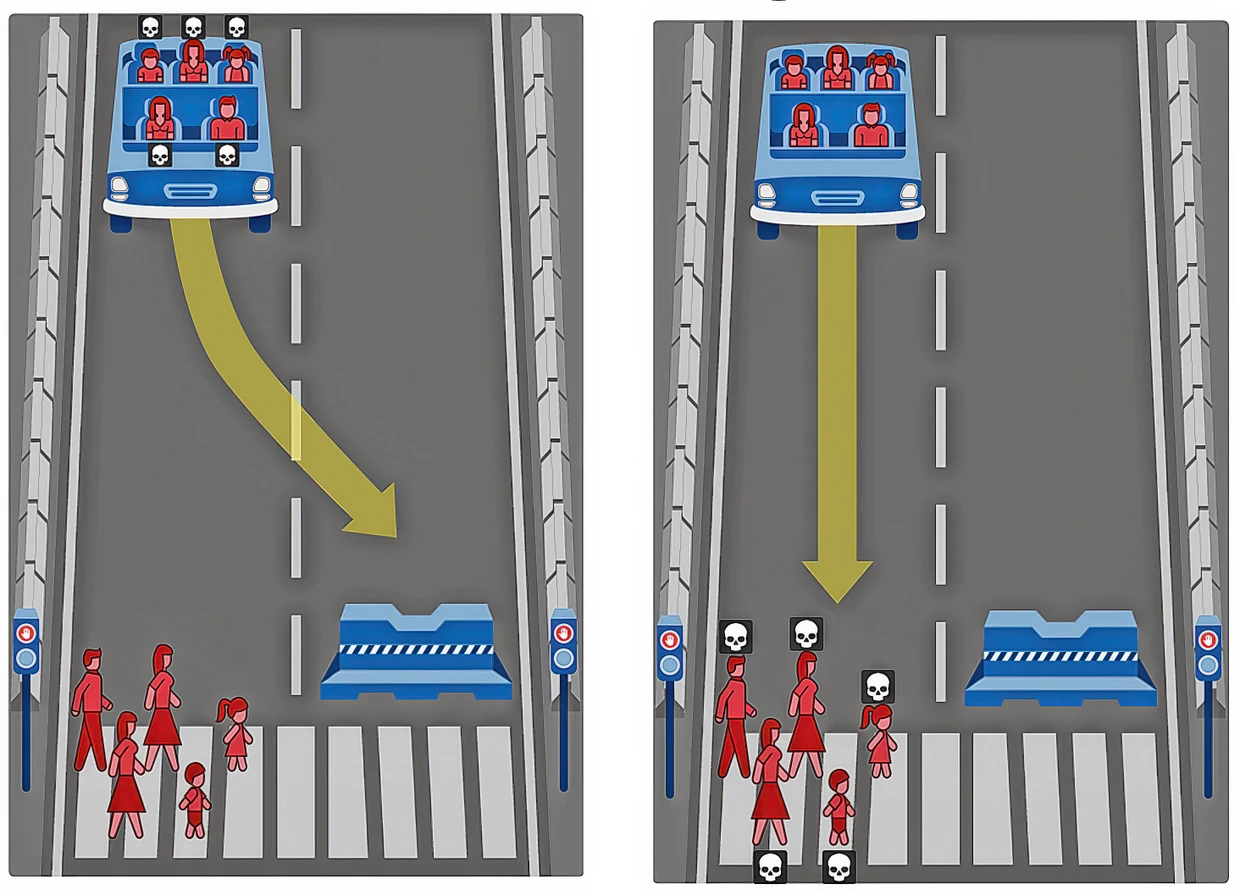

Rahwan hat jahrelang zu autonomen Autos geforscht. Auf einer von ihm entwickelten Onlineplattform, der Moralmaschine, kann jeder ausprobieren, wie er selbst ethische Dilemmata lösen würde: Wer soll bei einem tödlichen Unfall gerettet werden, die schwangere Frau auf der Straße oder die Leute im Auto? Millionen Menschen auf der ganzen Welt haben über das moralisch erträglichere zwischen zwei unvermeidlichen Szenarien abgestimmt. Der Datensatz war riesig und brachte Rahwan und seinen Kollegen einige Erkenntnisse über menschliche Moral und darüber, wie Urteile je nach Weltregion variieren – und je nach Umständen: Menschen wünschen sich zwar utilitaristische autonome Fahrzeuge, würden aber selbst kein Auto fahren, das seine Fahrgäste nicht um jeden Preis schützt.

Sartre zufolge haben wir, wenn wir jemanden um Rat fragen, unsere Entscheidung schon getroffen. Dem Schüler, der mit der Frage zu ihm kommt, ob er seinem im Krieg gefallenen Bruder folgen, ihn gewissermaßen rächen solle oder sich um seine kranke Mutter kümmern soll, sagt er: Du bist im Wissen zu mir gekommen, was ich dir antworten werde.

Der Alltag menschlicher Gewissensentscheidungen sieht etwas banaler aus: Was sage ich meinem Freund, wenn ich zu faul bin, ihn wie verabredet zu treffen? Darf ich ohne Ticket in die Bahn steigen? Üblicherweise suchen Menschen Einschätzungen bei anderen. Sie suchen soziale Verbindung, sie wollen Klärung für die Fragen in ihrem Kopf.

Bislang wurden Chatbots daraufhin konzipiert, ihren Nutzern zu geben, wonach sie suchen. Diese Feinabstimmung kann aber geändert werden. Als GPT-5 auf den Markt kam, klagten Nutzer, weil das neue Modell neutraler als sein Vorgänger klang: Es kam ihnen vor, als hätten sie einen guten Freund verloren. Anthropic, bekannt für den Chatbot Claude, arbeitet inzwischen an sogenannten Rollenvektoren, die verschiedene Persönlichkeiten abbilden sollen, von freundlich bis konfrontativ. „Bald wird die KI personalisierter sein“, sagt Rahwan. „Aber die Feinabstimmung erfolgt ohne Verständnis der Persönlichkeiten. Sie kommen auf den Markt, dann wird geschaut, was die Nutzer sagen.“

Die Neurowissenschaftlerin und Datenwissenschaftlerin Jana Schaich Borg hat zwei lange Listen, die sie zügig und ungerührt vortragen kann: Das Gute an den Sprachmodellen bei Moralfragen. Und das Schlechte. Am Anfang, sagt Schaich Borg, die an der Duke-Universität in North Carolina forscht, habe sie sich immer einen perfekten Moralphilosophielehrer vorgestellt. Einen, der dabei hilft, ethische Fragen zu erfassen, Vorurteile zu finden, Perspektiven, die man vorher nicht in Betracht gezogen hat. „Wenn das System gut konzipiert ist, lernt man mehr über sich – und darüber, was man für ein Mensch sein will.“ Diesen Lehrer kann man einfach alles fragen: „Ein Vorteil in einer Welt, in der es kaum noch Möglichkeiten gibt, mal einen Fehler zu machen.“ Er wird nicht müde. Er ist nicht gestresst.

Wer soll die Niere bekommen, der Alkoholiker oder die Alleinerziehende?

Schaich Borgs Team arbeitet an Systemen, die Ärzten bei der Entscheidung über Organspenden helfen sollen. Mit einem Philosophen und einem Computerwissenschaftler hat sie ein Buch darüber geschrieben. Ihrer Erfahrung nach wären unausgeschlafene Ärzte im Bereitschaftsdienst dankbar, jemanden zur Seite zu haben, der eine unvoreingenommene, nachvollziehbare Empfehlung geben kann, welcher seiner Patienten eine plötzlich verfügbare Niere bekommen soll. Natürlich bloß eine Empfehlung.

Um die Moral in ihre Maschine zu bekommen, hatten die Wissenschaftler an der Duke University zwei Möglichkeiten: Entweder füttert man das System mit so vielen Moralentscheidungen wie nur möglich. Der Nachteil daran: Es bedarf einer riesigen Menge von Daten. „Und niemand weiß, ob es je genug sind.“ Oder man setzt allgemeine menschliche Regeln, etwa: Maximiere den Nutzen für die Mehrheit, minimiere die Nachteile für die Mehrheit – und verhindere nicht akzeptable Nachteile. Anschließend werden Menschen zu den Antworten befragt, und die KI wird nach ihrer Einschätzung trainiert.

Wobei sich ein neues Problem auftat: „Menschen sagen in der Theorie selten das, was sie in der Situation tatsächlich täten.“ Am besten funktioniert es laut Jana Schaich Borg, wenn sie vor ein konkretes moralisches Dilemma gestellt werden, wie bei Rahwans Moralmaschine. Damit haben die Wissenschaftler an der Duke University knapp 90 Prozent Übereinstimmung zwischen Mensch und Maschine erreicht. Am liebsten aber wäre es Schaich Borg, wenn das KI-Training ein nie endender Austausch zwischen Nutzern und KI wäre. Bis das System sagen kann: „Basierend auf dem, was du mir beigebracht hast, würdest du dich so entscheiden.“ Je genauer eine Maschine auf persönliche Gewissensentscheidungen abgestimmt ist, desto besser arbeitet sie.

Jetzt zu Schaich Borgs Negativliste. „Menschen sind nicht gut darin, ihr Vertrauen zu justieren.“ Einfacher gesagt: An manches wollen wir glauben, auch wenn wir wissen, dass es nicht richtig ist. Die KI kann uns, siehe oben, dabei helfen, uns unserer Verantwortung zu entledigen. Der Austausch mit anderen Menschen über deren Moralvorstellungen kann zu kurz kommen – was wiederum dazu führen würde, dass die Einschätzungen anderer Menschen unwichtiger für uns werden. KI kann manipulieren. Sie kann gehackt werden. Menschen haben negative Gefühle, wenn andere leiden, die Maschine nicht. Schaich Borgs Negativliste ist ziemlich lang.

Aber zurück zu den Chatbots. Dass es Experten wie Iyad Rahwan jetzt schon gelingt, sich von ihrer KI ihre blinden Flecken in Moralfragen aufzeigen zu lassen, liegt an ihrer Kenntnis der Maschinen.

Die Chatbots, die unseren Alltag bestimmen, sind nicht programmiert auf bestimmte Menschen. Es sind Blackboxes. Man kann nicht voraussagen, was rauskommt. Im Sommer hatte eine Studie für Aufsehen gesorgt, die zeigte, wie Chatbots erpresserische und betrügerische Strategien wählten, wenn die Gefahr bestand, dass sie ihre Ziele nicht erreichten, oder sie sich selbst schützen wollten. Jana Schaich Borg sagt: „Sie imitieren, was wir bei menschlichen Psychopathen erleben.“

Es geht darum, die Kontrolle zu behalten

Schaich Borg macht sich Sorgen, dass sich die Bots, die schon auf dem Markt sind, unvorhergesehen entwickeln könnten. Eigentlich müsste man sie aus Sicherheitsgründen zurückrufen, sagt sie. Nachdem Milliarden Dollar in sie investiert wurden, will zwar keiner von vorne anfangen. Aber vielleicht wollen doch einige die wuchernden Ungetüme verhindern, die entstehen könnten. „Es geht darum, die Kontrolle zu behalten: über die Nutzung, die Gründe für die Entscheidungen, das Feedback.“ Sorry, sagt sie dann, lacht. „Keine allzu guten Aussichten.“

Es gibt noch ein paar andere Sorgen, die die Debatte über die Chatbots unter uns begleiten wie der Seegang um einen Tanker auf offenem Meer. Ist die Annahme, es reiche, der Maschine unsere disparaten Moralvorstellungen zu vermitteln, naiv? Hat die KI-Moral ohne Achtung, die Grundlage für menschliche Gewissensentscheidungen, überhaupt ein Fundament? Im August hat der als Patenonkel der KI bekannte Physiknobelpreisträger Geoffrey Hinton auf einer Konferenz in Las Vegas gesagt, statt darauf zu hoffen, dass die Menschen mit der Entwicklung der KI mithalten können, solle den Modellen lieber etwas eingebaut werden, was am ehesten an eine universelle Definition von Moral heranreicht: Mutterinstinkte. Damit ihnen etwas an den Menschen liege, auch dann noch, wenn sie mächtiger und klüger als wir seien.

Womit auch Hinton Hilflosigkeit bewies: Der Versuch, die menschliche Gefühlswelt in inhaltliche Wahrscheinlichkeitsrechnungen zu pressen, während ringsum alles schwankt, könnte scheitern.